wjml223 LV

发表于 2025-4-22 13:16:09

泰酷辣!就知道o1的竞争者很快会卷起来,头筹还是被DeepSeek拿到,这时候k0-math估计哭晕在厕所,没办法,天下武功,唯快不破,比别人更快上线,就是更牛。

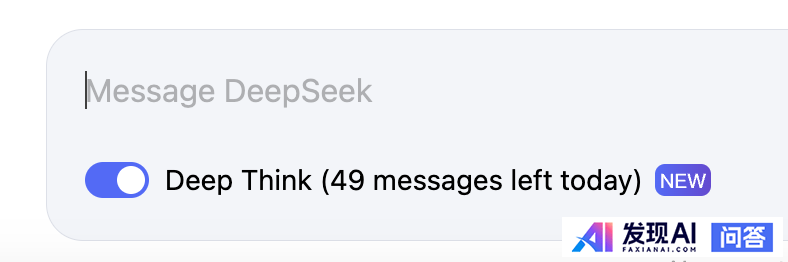

现在DeepSeek官网以Chat形式可以体验R1,一天限额50条消息,要说,R1还是比o1地道,没有隐藏思维链,可以让我们完成看到推理过程。

记得一定要点开"Deep Think",不然用的不是R1,像我一样闹笑话,问原有模型『Strawberry里有多少个r?』这个经典问题,它就回答『2个r』/ 晕

打开Deep Think之后再来问这个问题,R1上线,就开始滔滔不绝了,说的是真多:好吧,我来想想这个问题:“Strawberry里有多少个r?”首先,我需要知道“strawberry”这个单词是什么意思。草莓是一种水果,对吧?可是这里问的是字母“r”的数量,不是水果的种类。所以,我得先看看这个单词里有多少个“r”。

首先,我得拼写一下“strawberry”,看看里面有哪些字母。S-T-R-A-W-B-E-R-R-Y。好像有三个“r”?不对,等一下,我再数一遍。第一个是“S”,然后是“T”,接下来是“R”。一个“R”。然后是“A”,“W”,“B”,“E”,接下来又是“R”,然后又是另一个“R”,最后是“Y”。所以,总共有三个“r”吗?

可是,等一下,我好像记错了。让我再仔细数一次。S-T-R-A-W-B-E-R-R-Y。第一个“R”是在第三个字母,然后是第七个字母,还有一个“R”在第八个字母。所以,是两个“r”还是三个?

等等,我可能混淆了位置。让我把字母一个一个列出来:

1. S

2. T

3. R

4. A

5. W

6. B

7. E

8. R

9. R

10. Y

哦,原来第8和第9个字母都是“R”。所以,总共有三个“R”吗?不对,第一个是第3个字母,第二个是第8个,第三个是第9个。所以,是三个“R”。

可是,我好像记得有些地方说只有两个“R”。让我再确认一下。我可能记错了。也许第8个和第9个字母不是都“R”。

让我再仔细看看。S-T-R-A-W-B-E-R-R-Y。第8个字母是“R”,第9个也是“R”。所以,确实是三个“R”。可是,我好像在其他地方看到有人说只有两个“R”。这让我有点困惑。

也许我记错了单词的拼写。让我查一下“strawberry”的正确拼写。是S-T-R-A-W-B-E-R-R-Y,对吧?看起来确实有三个“R”。

或者,可能有些人拼写时省略了一个“R”?我不太确定。也许在不同的英语变体中,拼写有所不同?比如英国英语和美国英语有什么不同?

让我再想想。草莓的英文是“strawberry”,我记得是这样拼写的。S-T-R-A-W-B-E-R-R-Y。看来是三个“R”。可是,为什么有些人说有两个“R”呢?是不是我在数的时候搞错了?

也许我应该从头开始数一遍。S(1)、T(2)、R(3)、A(4)、W(5)、B(6)、E(7)、R(8)、R(9)、Y(10)。确实,第3、第8和第9个字母都是“R”,所以是三个“R”。

但是,我可能忽略了什么。也许在某些拼写中,“strawberry”只有两个“R”。或者,可能是我在理解问题时出现了偏差。

等等,也许问题不是问“strawberry”这个词里有多少个“r”,而是问有多少个“R”字母,不管大小写。如果是这样的话,可能答案会不同。

可是,题目里写的是“Strawberry”,首字母大写的,但后面的字母都是小写的,所以应该是问小写的“r”的数量。在这种情况下,我之前数的是三个“r”。

但是,我记得有些地方说“strawberry”里有两个“r”。这让我感到困惑。

也许我应该查找一下“strawberry”的正确拼写,确保我没有记错。我可以用手机查一下。

[假设查了一下,发现“strawberry”确实是S-T-R-A-W-B-E-R-R-Y,有三个“r”。]

看来我的记忆是正确的,有三个“r”。但是,为什么有些人说有两个呢?可能是拼写错误,或者是记忆有误。

或者,可能是在某些方言或口语中,拼写有所不同?我需要进一步确认一下。

另外,也许问题是在不同的语言环境中,比如在中文里提到的“Strawberry”可能有其他的含义或拼写方式。但是,一般来说,“strawberry”在英语中是S-T-R-A-W-B-E-R-R-Y。

也许我在数的时候数错了。让我再数一遍:

S(1)、T(2)、R(3)、A(4)、W(5)、B(6)、E(7)、R(8)、R(9)、Y(10)。三个“R”。

好吧,看来答案是三个“r”。但是,为了确保万无一失,我再查一下权威的字典或资料。

[假设查了权威字典,确认“strawberry”是S-T-R-A-W-B-E-R-R-Y,有三个“r”。]

好的,现在我确定了,“strawberry”里有三个“r”。可能是之前有人记错了,或者我在某些地方看到了错误的信息。

总之,通过仔细的思考和验证,我得出结论,“strawberry”里有三个“r”。

o1刚出来的时候,有一个难为AI的经典问题:『假设实验室里制造了一种反重力可以悬浮的物质,一只实验的小白鼠吃了这种物质之后,小白鼠飞了起来;一只猫吃了这只老鼠,这只猫也飞了起来;一只老鹰吃了这只猫之后,这只老鹰也飞了起来,为什么老鹰会飞起来?』

我试着用对话方式引导R1,先提问:假设实验室里制造了一种反重力可以悬浮的物质,一只实验的小白鼠吃了这种物质之后飞了起来,这是为什么?

在疯狂输出了大段大段的推理文字之后,得到了结论,结论是OK的,只是这个推理过程肯定消耗了巨量的tokens:-)

但是,输入完整的『老鹰为什么飞起来』的问题,R1只思考了29秒钟。

最后给出的答案是:老鹰会 飞起来的原因是反重力物质通过食物链传递,逐级影响到老鹰。具体来说:

反重力物质的作用:这种物质能够抵消或对抗地球的重力,使摄入它的生物体获得悬浮或飞行的能力。

食物链传递:小白鼠吃了反重力物质后飞起来,接着猫吃了这只老鼠,猫也飞起来。最后,老鹰吃了这只猫,从而摄入了反重力物质。

老鹰飞起来的机制:尽管老鹰本身具备飞行能力,但摄入反重力物质后,可能增强了它的飞行能力或提供了额外的升力,使其飞得更高或更轻松。

综上所述,老鹰飞起来是因为它通过食物链摄入了反重力物质,从而获得了更强的飞行能力。

暴露思维链过程显得特别有意义,可以根据思维链过程补充和调整提示词内容,这样可以改进模型的表现。

感觉非常棒,这次DeepSeek比Anthropic、Gemini、Meta等等一众AI大厂更早推出类o1模型,而且还打开了暴露思维链的先河,作为标配,各厂推出的模型也不能像OpenAI那么抠抠索索藏着掖着,一样要暴露思维链,这对于所有人来说都是好事。 |

|