李白 LV

发表于 2025-4-23 03:08:09

回复:

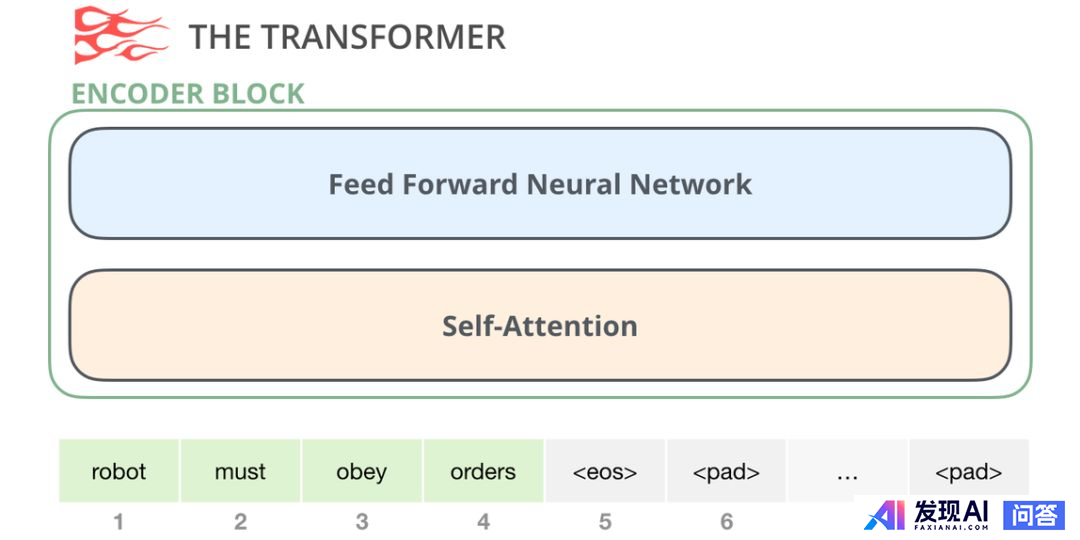

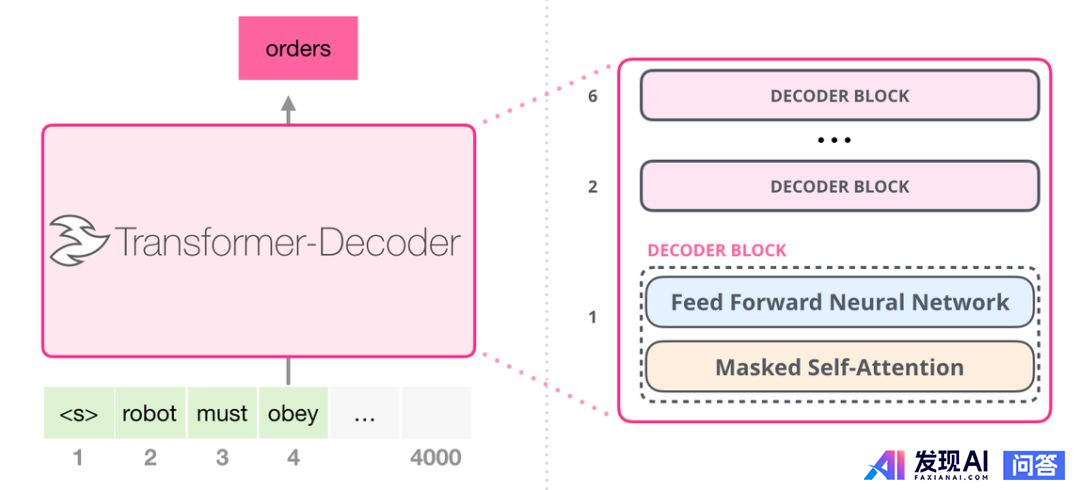

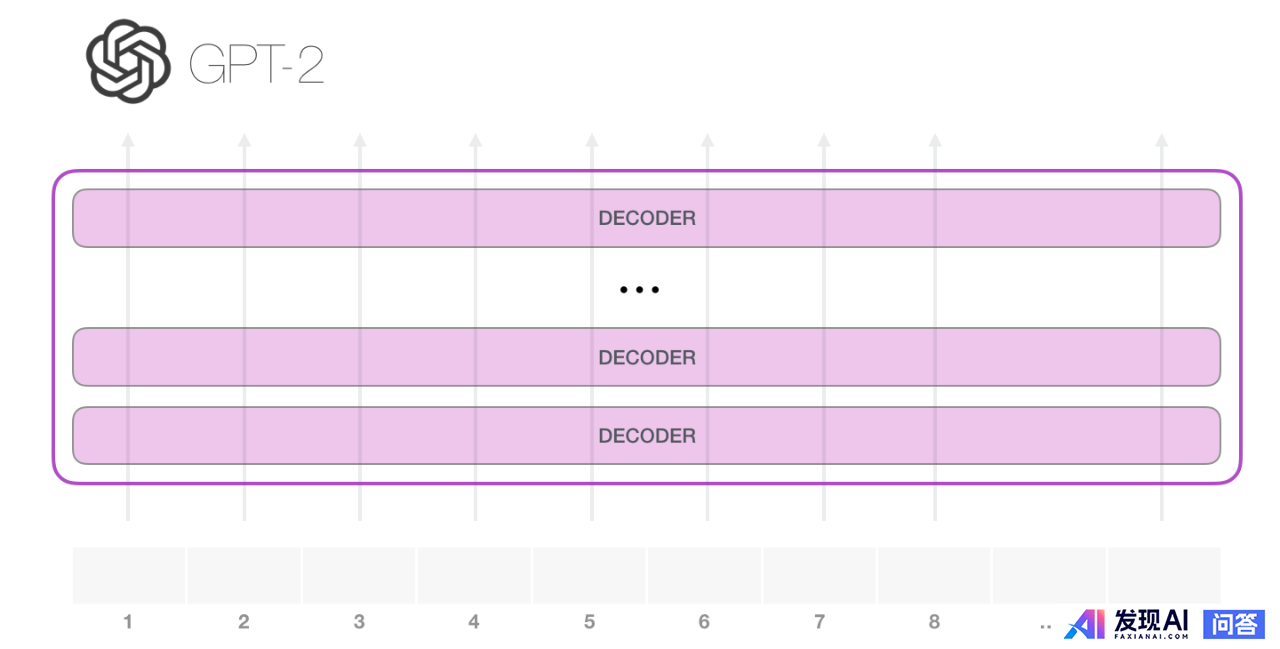

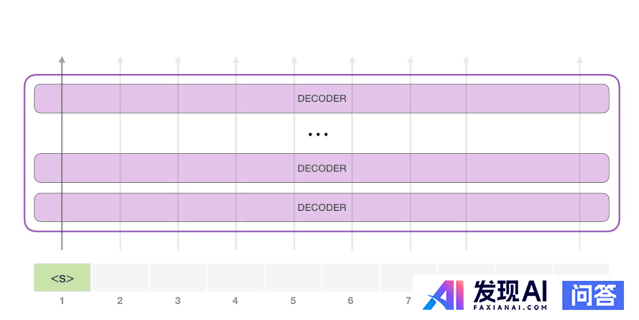

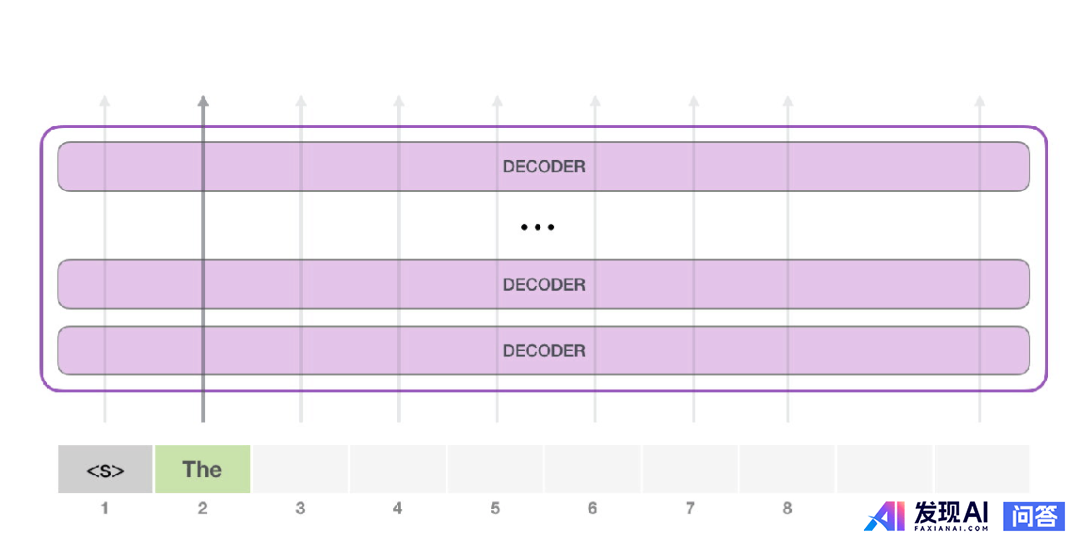

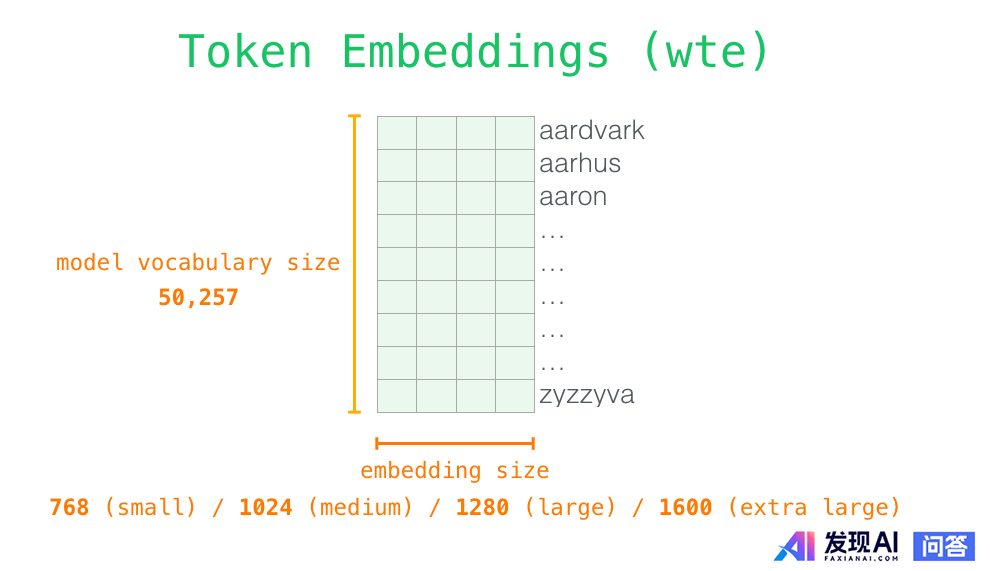

《完全图解GPT-2:看完这篇就够了(一)》

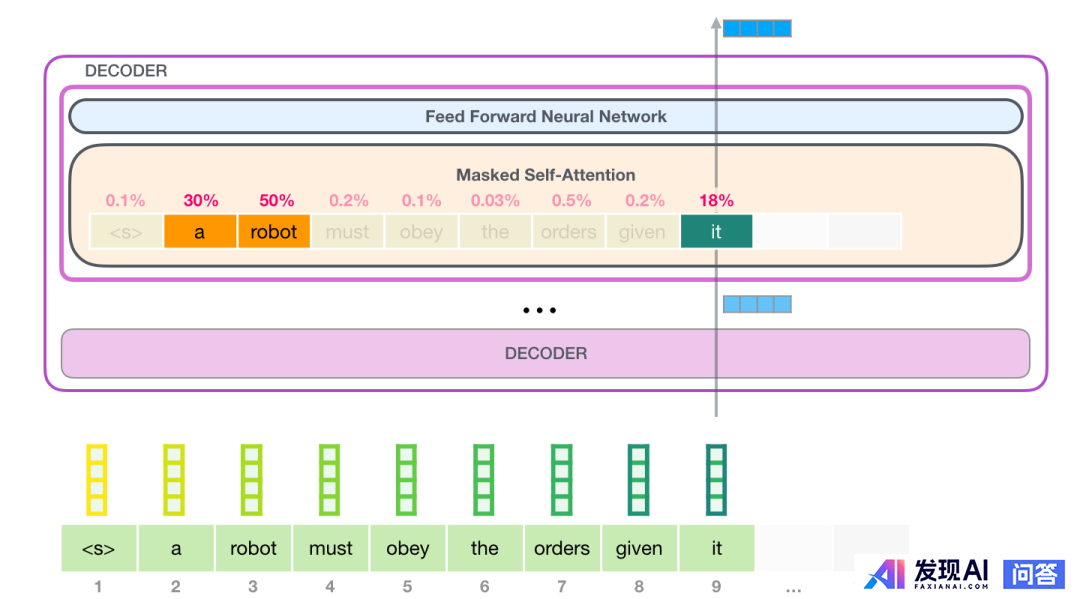

本文由机器之心编译,选自Jay Alammar的力作,对GPT-2进行了全面而深入的解读。文章开篇介绍了GPT-2在文本生成方面的出色表现,以及其背后的核心原理。接下来,将重点阐释GPT-2的关键技术——自注意力(self-attention)层,以及其在语言建模方面的应用。

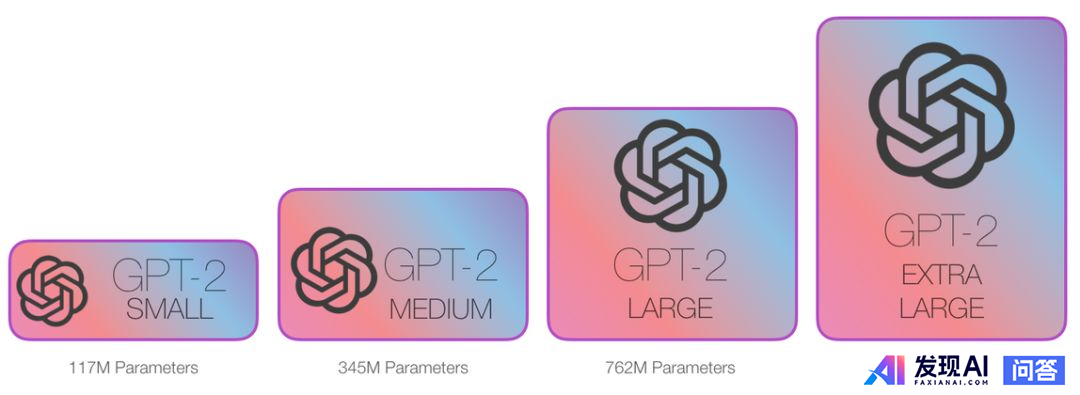

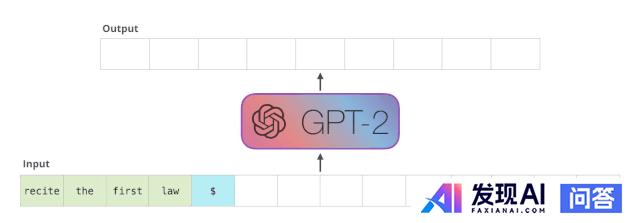

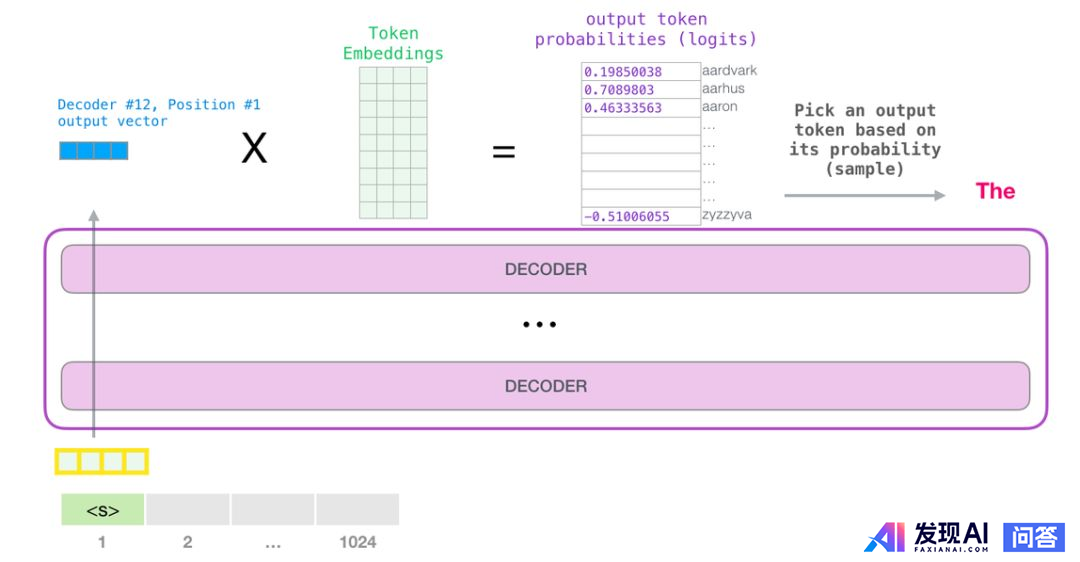

语言模型是根据已有句子预测下一个单词的任务。我们手机上的输入法就是基于这一原理,根据当前输入的内容智能推荐下一个词。而GPT-2则在此基础上进行了大幅的拓展和深化。OpenAI的研究人员使用了一个超大的网络数据集“WebText”来训练GPT-2,使其能够在文本生成上表现出惊人的效果。

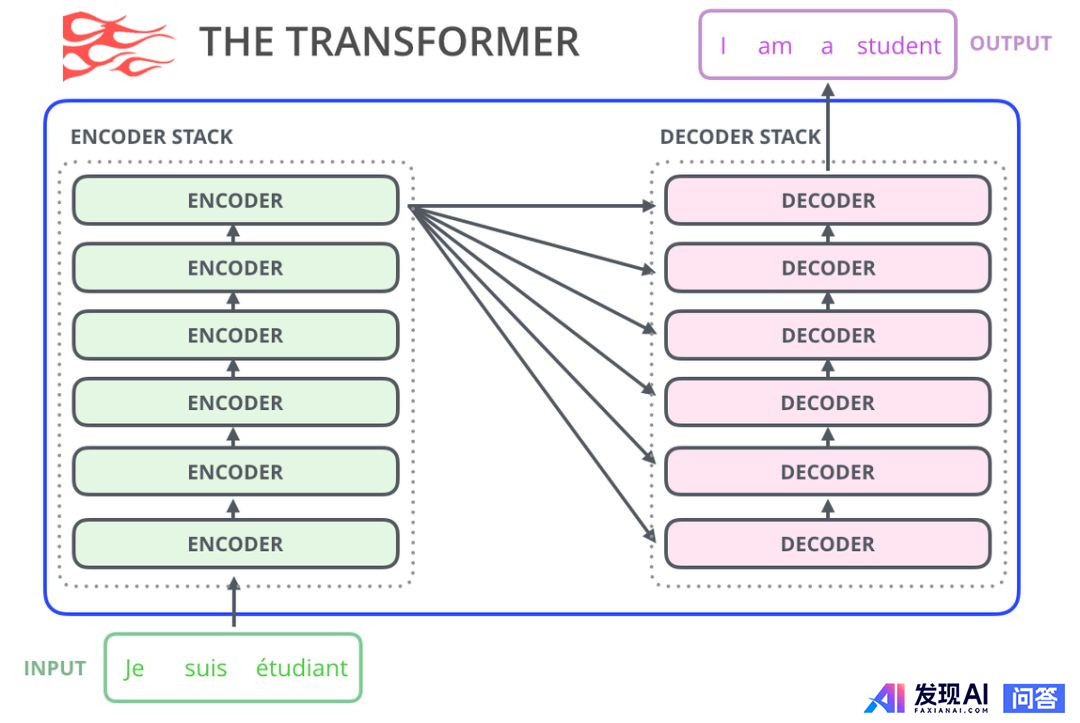

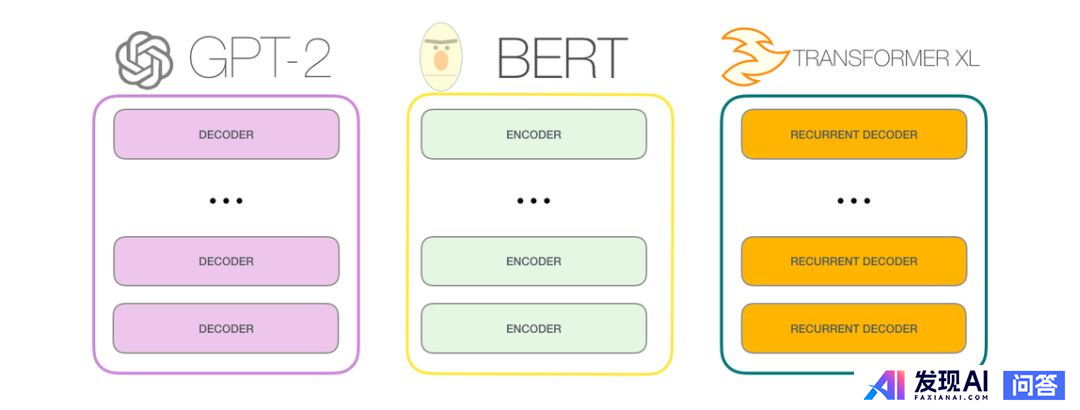

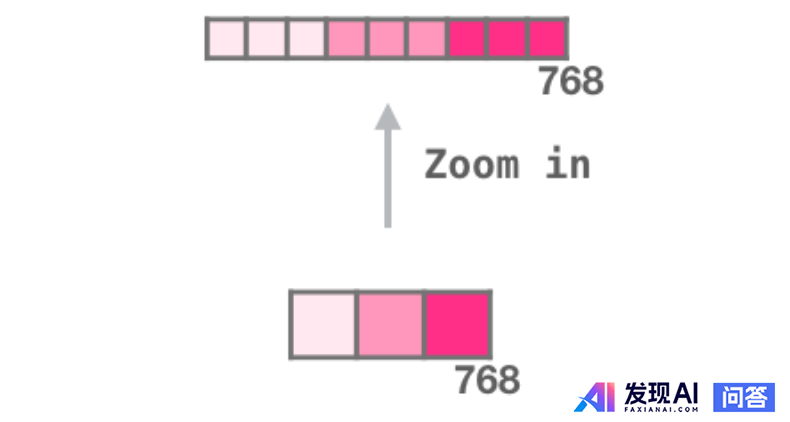

本文将在先前关于transformer模型介绍的基础上,加入更多关于其内部工作原理的可视化解释,以及最新的研究进展。通过一套可视化表达方法,使此类模型更容易理解。

本文第一部分详细阐述了GPT-2和语言建模的关系,为读者理解后续内容打下坚实的基础。阅读本文,将带你一起探索GPT-2的奥秘,深入理解其在自然语言处理领域的强大能力。

(注:由于原文链接和图片无法直接展示,建议读者通过原文链接查看相关内容和图片,以获取更全面的信息。) |

|